Статистика и прагматика «сильного ИИ». Одурение эпигонов

Всем привет, будущие рабы ИИ!

Мне кто-то из читателей как-то пенял, что не надо всё время писать так, вообще, о вечном, а нужно же и об актуальном. Вот как раз подоспела супер-актуальная тема: о «генеральном ИИ».

Я был два дня на ПМЭФ (по приглашению МИДа на их секцию, сам бы я не стал платить полтора ляма за пару дней на ярмарке тщеславия и прогулки по променаду «Я-в-обойме»).

Там я участвовал в секции МИД про регулирование ИИ, а также ходил на разные профильные секции «по ИТ», опять же про ИИ, про биометрию (тоже ИИ) и так далее. Дал интервью ТАСС — опять же разговор про цифровизацию и ИИ.

У меня сложилось впечатление, что не только на этих секциях, а практически на любой обязательно говорили про ИИ. В том числе на пленарке (хотя я часть её проспал в кресле перед большим экраном на площадке прессы).

Это понятно: мы уже год находимся внутри пузыря ИИ, идёт бешеная накрутка темы изо всех стволов, причём в основном теми, кто и знать толком не знает, что это.

Но есть особая, очень свежая тема: выдающийся труд Леопольда Ашенбреннера о ближайшем приходе Сильного ИИ и Супер-ИИ.

Это какой-то чувак, работавший в OpenAI, а потом, видимо, открывший какую-то свою контору или чисто сайт под названием Situational Awareness. Это тоже, видимо, какое-то модное шумовое слово.

Он наслесарил 165 страниц писанины про «Общий ИИ» — осторожно, по ссылке сразу прилетает этот нетленный TL-DR. Можно и с сайта прочитать, по ссылке выше.

AGI ((General Artificial Intelligence) — так теперь называется «Сильный ИИ», слегка себя скомпрометировавший ранее (он не пришёл в объявленные сроки, но говорить об этом некрасиво). А также он написал и про ASI (Artificial Superintelligence) — Супер-ИИ, который неизбежно придёт на смену Сильному ИИ.

Все у нас тут же начали эту писанину бешено цитировать. И дело тут не только в том, что он где-то там работал, известен или написал что-то очень содержательное.

Дело во вторичности наших СМИ (я об этом уже писал), и во вторичности, эпигонстве наших «евангелистов ИИ» из «цифровых платформ» и «экосистем». Эти «евангелисты» просто переводят Гуглом всякие угарные выдумки из Долины и некритично пересказывают их прессе и своему начальству.

А их программисты копируют, скачивают, цельнотянут архитектуры, модели, датасеты, перекрашивают, приклеивают молдинги и шильдики, «дообучают» и выдают за «чисто свои».

Я тут уже писал про то, как насквозь отечественные бредогенераторы сначала «переводят в уме» запрос (промт) на английский, а потом уже синтезируют то, что получилось — гайку вместо ореха и т. п.

Про то, как они отказываются разговаривать про то, чей Крым, про СВО, вообще несут нарратив западной «повесточки» в массы» — вообще уже будет в сотый раз. Почему, казалось бы.

Ну и вот представьте: вы всегда пересказывали «ИИ-нарративы» из Долины. И тут приезжает с пылу с жару новый угарный эпохальный нарратив про ИИ от уважаемого человека.

Ну, надо срочно пересказывать, а что ж ещё? И самое главное — успевай пересказывать первым, это обязательное требование!

Я лично слышал ссылки на эту писанину из уст практически всех выступающих на ПМЭФе про ИИ.

Александр Александрович Ведяхин — главный ИИ-оракул Сбербанка в ранге вице-президента, прямо сказал: «вот очень важный документ, мы его внимательно изучили, приняли во внимание, перестраиваем работу». Типа, мы тоже считаем основным риском появление Супер-ИИ!

Ведяхин при этом уже несколько лет во всех собраниях — где ему неизменно дают первое слово (Сбербанк же, национальный лидер ИИ) — говорит, что ИИ давно превзошёл человека.

И Андрей Незнамов — говорящая голова Сбербанка про ИИ — тоже писанину Ашенбреннера упоминал. Другие её тоже поминали, но банк старается захватить дискурс ИИ в РФ, забрать его под себя, поэтому они стремятся быть первыми пересказывающими, переводчиками сокровенного знания для русских начальников.

А вот главный по ИИ в Яндексе Саша Крайнов — ещё не читал великое произведение, в своей, казалось бы, профессиональной области. Это довольно показательно. Он, видимо, делом занимается.

И что же там пишет Ашенбреннер?

Вот оглавление, из которого уже многое понятно:

- I. From GPT-4 to AGI: Counting the OOMs

- II. From AGI to Superintelligence: the Intelligence Explosion

- IIIa. Racing to the Trillion-Dollar Cluster

- IIIb. Lock Down the Labs: Security for AGI

- IIIc. Superalignment

- IIId. The Free World Must Prevail

- IV. The Project

- V. Parting Thoughts

Пояснения:

- AGI — Artificial General Intellect, сильный ИИ, сравнимый с челвоеческим.

- OOM — order of magnitude, порядок величин.

- Alignment — управление ИИ, удерживание его в узде;

- ASI– Artificial Superintelligence, искусственный суперинтеллект, превосходящий человеческий;

- Free World — Запад.

Заметим, что опорная структура этого виртуального мира этим конкретным англосаксом строится прямо на уровне лексики, как всегда англосаксы и делают. Сначала наслесарить виртуальных наклеек для своего штрикод-пистолета, а потом начинаем их клеить вокруг на всё любое, очередями.

А бывает ли ИИ, сравнимый с человеческим? Очевидно, нет. Но вот же — слово-то уже есть. Значит, бывает. Есть и слово «Супер-интеллект»! Вот же — мы же его используем же! Значит, тоже бывает.

Свободный Мир — слово давно есть, мы все его используем, значит, он реально свободный. Это данность! Ну и так далее.

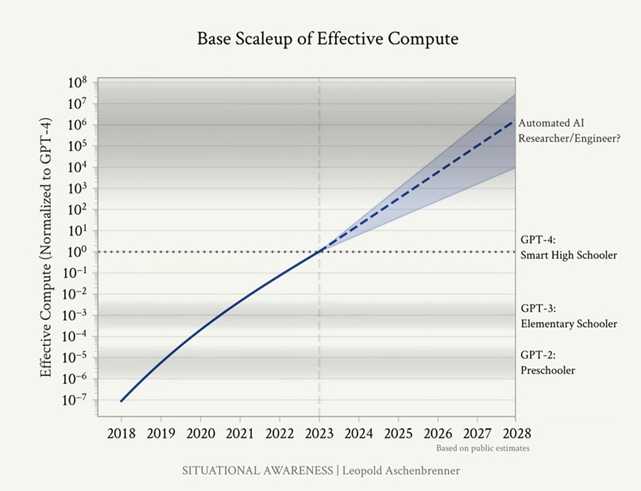

А вот пример того же втюхивания в виде графиков:

Оказывается, GPT-4 уже сейчас имеет интеллект, как у старшего школьника! Это факт — см. график. Вы что, не видите, что на графике?

При этом, конечно, ничего подобного никакой жопыте не показывает — да и не может в принципе. Но график же вот он. Нарисовано же.

Так делаются фактоиды — для эпигонов всех стран.

Примерное содержание эпохального труда

Читать сотни страниц камлания мучительно — но можно отдать в ЖПТ для суммаризации. Многие так и сделали:

· Появление Сильного ИИ — AGI — к 2027 году практически гарантировано.

· AGI — важнейший геополитический рычаг, актив. Это новое супер-оружие. Каждая страна стремится первой заполучить AGI, как когда-то атомную бомбу. Неважно, почему, нет времени объяснять.

· Для создания AGI потребуется вычислительный кластер стоимостью триллион долларов. Такие уже строят ИТ-гиганты США (например, Микрософт). Круто, да?

· Этот кластер будет потреблять количество электроэнергии, сравнимое со всем потреблением в США. Опа, опа, поняли?!

· Финансировать AGI будут ИТ-гиганты — OpenAI, Nvidia, Microsoft, Amazon, Google. Они уже закладывают квартальные бюджеты по 100 миллиардов долларов, по полтриллиона в год. А бабки же всё решают, разве нет?

· К 2030 году ежегодные инвестиции в ИИ будут восемь триллионов долларов. Эти затраты и изменения сопоставимы с Манхэттенским проектом и Промышленной революцией. Раз сопоставимы — значит, похожи и вообще неотличимы. Короче, всё ж уже ежу понятно.

· AGI, человеческий интеллект в машине — это промежуточная стадия. После его создания моментально произойдёт создание ASI, Сверх-интеллекта. AGI будет настолько умён, что начнёт сам себя развивать с огромной скоростью. Это же очевидно, не так ли?

Это — оружие!

Ну и есть вишенка на торте:

Супер-интеллект и Общий интеллект — это оружие. Значит, США должны бежать изо всех сил, чтобы получить AGI и ASI как можно быстрее. Как было с атомной бомбой. Бежать нужно быстрее главного врага — CCP. Главная угроза, образ врага теперь — CCP, это не СССР, а его идеологическая замена — Chinese Communist Party.

The Free World Must Prevail!

It’s a must.

Алхимик при маркграфе

Мария Захарова на сессии МИД на ПМЭФ про международное регулирование ИИ, где я тоже сидел в президиуме, сказала, что ИИ сейчас — это вроде алхимии. Такая алхимия ИИ — всё непонятно, много пустых разговоров и обещаний магии, никто не понимает, как это работает, а потом из этого может что-то получиться, как из алхимии получились физика и химия.

Мысль про сходство — в целом правильная, но требует уточнений. Я там не стал возражать (хотя Крайнов из Яндекса или кто-то ещё возразил), но это всё-таки не алхимия дала нам химию и физику. На самом деле будущие химики и физики с алхимиками разошлись от камня с надписью про совесть и пользу — химики и физики пошли направо, изучать Разумный замысел Творца и придумывать полезное, а алхимики — налево, получать силу от демонов и заклинаний и делать бабло из воздуха.

В случае же обсуждаемой телеги про Сверхразум ИИ — здесь перед нами именно алхимик. Он требует денег от курфюста Баварии на последнюю, решающую стадию выработки Философского камня. Нужен кластер на триллион долларов — и золотой ключик у нас в кармане.

Он даже почти и не скрывает природы своих высказываний:

We’re literally running out of benchmarks.

«У нас даже критериев уже не осталось»!

Ну и в самом деле, чем вы будете мерить Сверхразум? А раз критериев не осталось — нужно просто верить экспертам.

Схемы рассуждений там вообще очень своеобразные.

Логические скачки через пропасть

Как известно, кидалово Апории Зенона про Ахиллеса и черепаху в чём? В том, что от рассуждения «поделим расстояние между Ахиллесом и черепахой пополам, потом ещё пополам, и так до бесконечности будем мельчить» происходит внезапный (но не осознаваемый слушателем) перескок к « А значит, Ахиллес никогда не догонит черепаху».

То есть от бесконечно малых интервалов времени (огромные отрицательные степени двойки) манипулятор вдруг незаметно перескакивает к бесконечно большому интервалу времени («никогда»). Просто с помощью стандартного оператора демагогии «значит». Понятно, что из одного другое — не следует.

нет в апории зенона

никакой загадки

не догонишь черепаху

со стрелою в пятке

Здесь та же история: ни из чего не следует, что скоро будет AGI, равный человеку. Ни из чего не следует, что он вообще возможен. Ни из чего не следует, что дальше внезапно возникнет Сверхразум ИИ. Ни из чего не следует, что это вообще возможно.

Ни из чего не следует, что «увеличение порядков величин» даст повышение «качества» ИИ.

Все эти лакуны, пустые звенья, разрывы заполняются просто живостью изложения, наукообразием и лексическими операторами демагогии «значит», «следовательно», «очевидно, что».

То есть брат Леопольд в своей келье просто счастливо прыгает через логические пропасти и обрывы на пегасе воображения, с крылами «Ложь» и «Демагогия».

На самом деле, все эти ЖПТ проклятие Китайской комнаты — не преодолели. Советую почитать про неё — в частности потому, что это познавательно, а также потому, что ни Ашенбреннер, ни наши эпигоны этого интеллектуально сложного рассуждения — явно нечитамши.

То, что ЖПТ оперирует текстами или картинками, вовсе не означает понимания. И в общем, мы так-то, вчуже понимаем, что никакого понимания там нет, а есть манипуляция токенами, довольно изощрённая и создающая впечатление.

Но есть и реальные разрывы между ИИ и жизнью, которые технология тоже не перепрыгивает.

Реальные разрывы

Прагматика

Ну, вот читает GPT тексты и графику. Все, какие в мире есть. В них что — есть все знания мира? Вовсе нет. В них есть примеры лексического выражения каких-то и некоторых мыслей, а ещё точнее — языковой код для запуска генерации мыслей в голове человека, что мы обсуждали ранее.

Мы помним общее место, что в тексте по сути смысла нет — в нём есть код для запуска процесса создания смысла в голове реципиента. Смысл вообще нами генерируется из текстов, на основе общей культурной и эмпирической базы, на основе жизненной прагматики, квалиа или феноменального опыта.

И в этой голове есть прагматика реального мира, эмпирика, к которой человек прикладывает смысл, извлекаемый из текстов. Она ИИ неизвестна — и неизвестно, как он в принципе мог бы до неё добраться, потому что из текстов, графики и видео она вообще-то не извлекается.

Именно поэтому графические бредогенераторы до сих пор рисуют руки с разнообразным числом страшных многосуставных пальцев и большим пальцем не с той стороны руки: из статистики рисунков и фото с руками эта прагматика добывается плохо. А гайки — десятиугольные, с рубчиками, как у презерватива, вместо резьбы.

Эту конкретную проблему разработчики полечат (я думаю, полечат специально, практически руками), а кое-где уже полечили, но таких проблем отсутствия прагматических знаний у ИИ — тысячи.

Недавно мне рассказал один из читателей сего блога пример из его профессиональной деятельности. Допустим, хочется разобрать («распарсить») автоматически товарные описания, например, смартфонов. Их можно брать из описания производителей, например, ёмкость аккумулятора — 4000 миллиампер-часов. А также из отзывов потребителей, в духе «нормально держит, почти целый день». Или «держал двое суток». Ясно, что GPT тут проблему решит легко и быстро.

И вдруг возникает проблема низкого или отсутствующего качества такого парсинга. Как соотнести заявленную ёмкость в ампер-часах и представления пользователей о том, что такое «нормально», и в каких условиях «нормально» (скажем, интенсивное использование или малые нагрузки)? Внезапно оказывается, что:

- А) нужных текстов — мало. Вот просто мало, их не хватает для обучения никакой LLam’e или GPT.

- Б) непонятно, что именно сводить с чем — пользователи вообще не обсуждают ёмкость и аккумулятор.

Вообще с полей ИИ-войны приходят страшные вести, что дело даже не в триллионных деньгах и потолке производства графических карточек — в Интернете тексты кончились. А в узких предметных областях их и никогда не было достаточно для «самообучения» БЯМ.

В результате попытки использовать большие языковые модели в реальной деятельности, с приемлемым качеством, приводят — в 2024 году, в пору великого триумфа БЯМ! — к необходимости нанимать лингвистов, составлять онтологии, фиксировать конкретные лексические реализации признаков и т. п. А это внезапно дорого — против обещаний, что теперь надо только кнопку нажать. Ну и немодно же. Это же фу-фу-фу, старьё. Так делали двадцать лет назад!

По сути, современные успехи ИИ в «общении» и «анализе» — это такие восторги родителей по поводу «достижений» ребёночка. Ой, какой умненький, смог игрушку сломать! Смог попасть мороженым не в ухо, а в рот!

Ребёнок этот — увы, изначально слепоглухонемой инвалид с водянкой мозга, который никогда не увидит реального мира.

Ну какой там старшеклассник. Старшеклассник, хотя и поражён в правах в силу умственной и эмоциональной незрелости (не может покупать алкоголь и сигареты, избирать и быть избранным, владеть оружием и водить автомобиль) — может думать. ИИ — не может.

А как же он «всё захватит»?

Главная же страшилка — как ставший сверхумным ИИ захватит мир, начнёт управлять всем. Нечеловеческим способом и с нечеловеческими целями.

Брат Леопольд прямо называет его «alien» и подробно объясняет, что Супер-интеллект станет настолько умнее нас, что мы никак не сможем понять, чего он хочет, что он делает, каким способом и т. п. Есть ли там какие-то риски в принципе. И какие именно.

А значит, и ограничить, изначально наложить «три закона робототехники» — мы не сможем: ведь Супер-ИИ быстро поймёт, что лгать, обманывать и кидать кожаных ублюдков — эффективно, а значит, так и надо поступать. И вот тогда…

— Мущщина, я вас боюсь!

— Почему вы меня боитесь?

— Потому что вы меня изнасилуете!

— Да вы же на четвёртом этаже, а я на улице!

— А я сейчас спущусь!

Но тут есть второй разрыв — физический. ИИ обучается на текстах и графике, на других интеллектуальных продуктах. Ну и ладно, казалось бы.

Но доступа к физическим системам у ИИ — пока нет. Точнее, кое-где уже есть — в дронах-камикадзе, в беспилотных авто и поездах, даже при управлении нагрузкой на АЭС и ГЭС. Но это никакой не «сильный» ИИ, а простые и замкнутые системы, подобные управлению системой лифтов в многоэтажном здании (лифты — это тоже ИИ, сюрприз).

Эти системы имеют узкую, формализуемую задачу, не соединены с Интернетом, не имеют свойств самообучения, не являются «чёрным ящиком». У них везде есть «кнопка останова», средства внешнего контроля корректности работы и т. п.

Ну и кто же пустит «сильный» ИИ к масштабному управлению реальным миром? Мы что, отдадим «сильному» ИИ управление городской инфраструктурой, транспортом, производством логистикой, энергетикой, медициной, правопорядком и армией? Запуском ядерных ракет?

А зачем?

Зачем нужен неконтролируемый «чёрный ящик» в критической инфраструктуре? Это же был бы полный идиотизм, тем более, что есть многочисленные опасения и предполагаемые ужасные риски?

На этот вопрос клянчащий алхимик Ашенбреннер как раз отвечает:

What’s more, I expect that within a small number of years, these AI systems will be integrated in many critical systems, including military systems (failure to do so would mean complete dominance by adversaries).

Если не встроим ИИ везде в критическую инфраструктуру — враги победят!

Не правда ли, прекрасно? Алхимику важно обозначить важность и нужность, необходимость своего Философского камня для сильных мира сего, которым он облизывает тарелки: без Камня — никуда, иначе враги победят. Враги ясно обозначены — это кровавые авторитарные коммунисты Китая. Они тянут свои когтистые лапы к ИИ, чтобы поработить всех своей автократией.

Потому что враги, они же враги. Они точно применят это Когнитивное Ядерное Оружие, если первым его не применит Свободный мир.

Дальше брат Леопольд безудержно фантазирует, как Супер-интеллект достигнет, распространится, проникнет, захватит и начнёт управлять тем, что ему не поручали и не делегировали.

И вот тут хотелось бы осторожно спросить: а как же он это сделает, ведь важные системы не подключены к Интернету?

А мы щас подключим!

В общем, я советую этот алхимический опус почитать самостоятельно. А наш техдир Крибрума рекомендует также почитать бюджет DARPA, говорит, очень познавательно: того, что этот дурак пишет — не будет, а вот что ДАРПА пишет — боюсь, будет.

Что будет и на чём сердце успокоится

Моё личное мнение такое:

1. Бояться надо не Сильного ИИ и не Суперразума, который всё захватит и поработит, а очень умных и злых людей, управляющих ИИ. Мы этих людей знаем. Например, это кадровый разведчик Эрик Шмидт, приставленный присматривать за молодыми балбесами Брином и Пейджем, работавший 20 лет гендиректором Гугла, имеющий состояние в 26 миллиардов долларов.

Прикольно, что про него в русской Википедии нет многих показательных деталей, а в английской — есть:

«In March 2016, it was announced that Schmidt would chair a new advisory board for the Department of Defense, titled the Defense Innovation Advisory Board. The advisory board serves as a forum connecting mainstays in the technology sector with those in the Pentagon»…

«From 2019 to 2021, Schmidt chaired the National Security Commission on Artificial Intelligence»…

Сейчас Шмидт основал компанию Белый Аист на Украине, которая делает дроны-камикадзе с ИИ. Автономных убийц с неба. Обещает создать супер-технологию и с ней победить русских. Ну и тестирует дронов-убийц на самом лучшем полигоне современности, чтобы продавать потом по всему миру.

Вот кого нам надо бояться.

2. Пузырь ИИ сдуется. Он всегда сдувается. Я видел три пузыря ИИ до этого.

Истерика по поводу «Новой экономики» и Интернета была не меньше, а больше. И сдулась. См. предыдущий пост про «Клютрейн манифесто».

И доказательств «кардинального изменения мира» было в 1999 году достаточно — вот же Гугл, вот же сайт для доставки памперсов, вот онлайн-казино — что ещё нужно?

Истерику социальных сетей все уже забыли, а она была круче. И сдулась.

И мир действительно изменился после прихода Интернета. И после вхождения социальных сетей в обиход. Но не так, как вдохновенно пророчили певцы Нового мира. Проще, умереннее, медленнее. И по-другому.

Конечно, после сдувания ИИ-пузыря останется — как обычно бывает — пучок полезных применений. На «плато продуктивности» по Гартнеру. Я эту картинку уже показывал:

3. ИИ не захватит мир. Но причинит очень много неприятностей по приказу своих хозяев. Я лично уверен, что эти два разрыва ИИ с действительностью, виртуальности с реальностью — когнитивный и физический — преодолены не будут.

Нет, нищепанк по Мараховскому, конечно, распухнет и всосёт в себя большую часть человечества, отняв в них их ненужные алгоритмизуемые работы и дав им ненужные электронные развлечения. Но никакого захвата мира «триллионнодолларовым кластером» Скайнета — не будет.

А вот очередные мегапроекты DARPA, роботы-убийцы, управление полем боя, умные рои дронов, чипы в мозгу универсальных солдат, умные кибератаки, супер-эпидемии, генетическое оружие — будут, конечно. И отстать нам нельзя — иначе нас сомнут, как говорил один разработчик социальной реальности.

Жить станет хуже, жить станет веселее, что тут ещё скажешь.